Simulationen

In diesem Lerngebiet geht es um die Rolle von Simulationen in der Wissenschaftsmethodik sowie um praktische Einblicke in die zugehörige Arbeitsweise.

Simulationen haben sich als drittes Standbein des wissenschaftlichen Erkenntnisgewinns etabliert; die Informatik fungiert daher in einer Vielzahl von Fachgebieten als Hilfswissenschaft.

Die Wissenschaftliche Methode

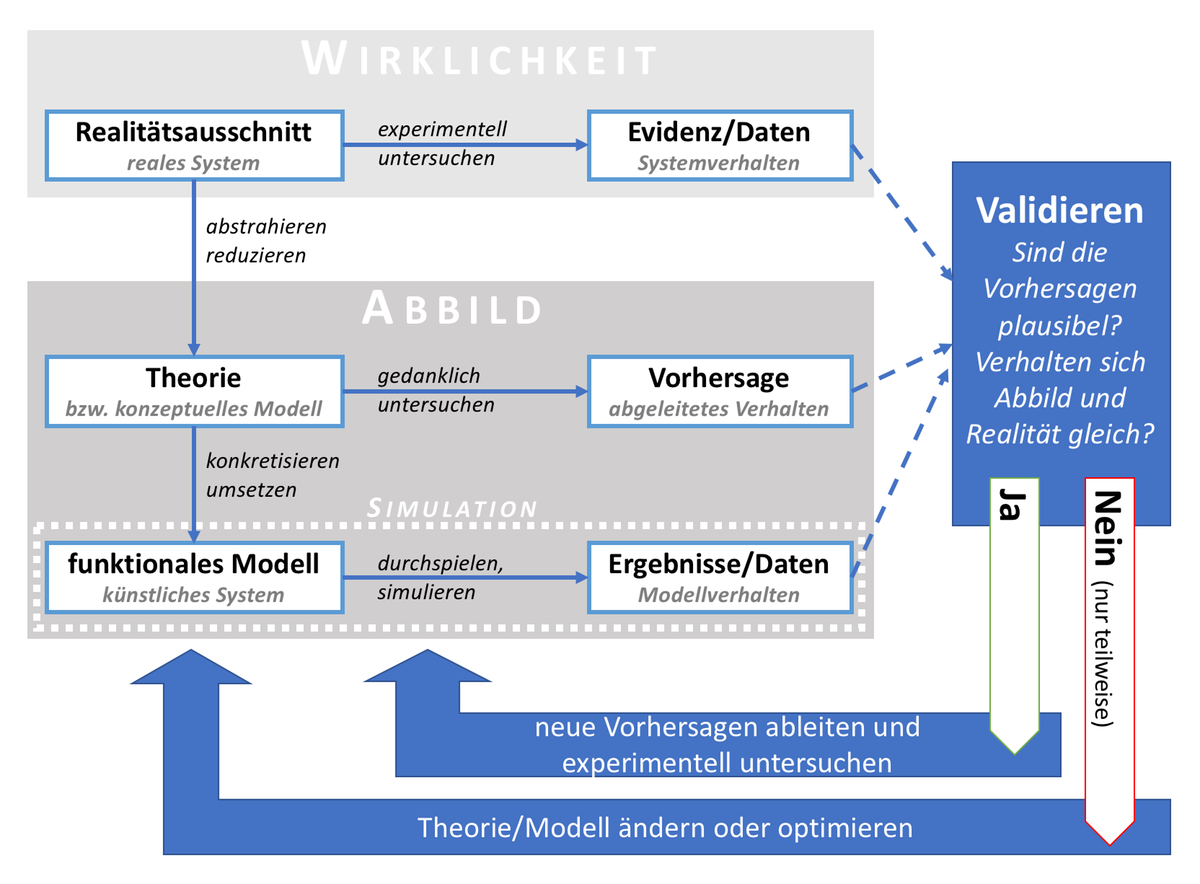

Schon immer haben Menschen versucht, sich die Welt zu erklären – aus reiner Neugier, oder um ihr Verständnis natürlicher Phänomene zum eigenen Vorteil einzusetzen. Konkret bedeutet das, man entwickelt eine Theorie, also eine mögliche Erklärung für ein Phänomen, mit dem man sich in seiner Lebenswelt konfrontiert sieht. Anschliessend versucht man, die Theorie anhand von weiterer Evidenz – also konkreten Beobachtungen – mit der Wirklichkeit abzugleichen.

Seit dem Mittelalter hat sich aus diesem grundlegenden Mechanismus das System der Wissenschaft entwickelt. Dabei ist der Kern, dass gewisse Ansprüche an wissenschaftliche Theorien und auch an wissenschaftliche Evidenz gestellt werden.

Theorie

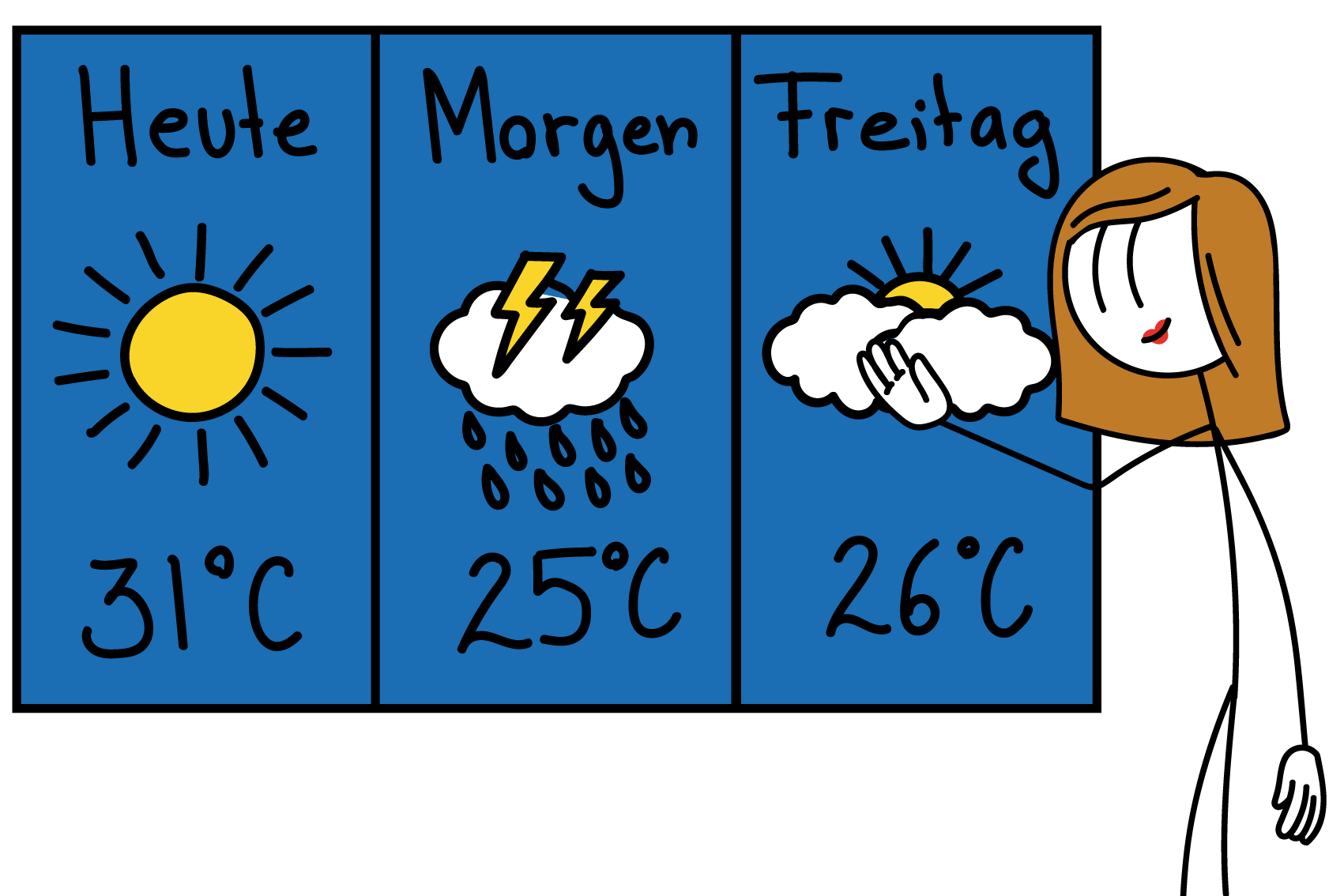

In der Wissenschaft bezeichnet Theorie ein System wissenschaftlich begründeter Aussagen, das dazu dient, Ausschnitte der Realität und die zugrundeliegenden Gesetzmäßigkeiten zu erklären und Prognosen über die Zukunft zu erstellen. Im Allgemeinen entwirft eine Theorie ein Bild (Modell) der Realität. In der Regel bezieht sie sich dabei auf einen spezifischen Ausschnitt der Realität. Eine Theorie enthält in der Regel beschreibende (deskriptive) und erklärende (kausale) Aussagen über diesen Teil der Realität. Auf dieser Grundlage werden Vorhersagen getroffen.

Quelle: Wikipedia, Theorie

Salopper formuliert: Eine Theorie ist eine begründete (aber nicht bewiesene!) Erklärung für reale Phänomene oder Prozesse. Um wissenschaftlichen Ansprüchen zu genügen, muss eine Theorie zudem einige Minimalanforderungen erfüllen:

- Eine wissenschaftliche Theorie muss explizit sein, d.h. es muss Einigkeit darüber bestehen, was genau die vorgeschlagene Erklärung ist.

- Eine wissenschaftliche Theorie muss widerspruchsfrei sein, d.h. die Erklärungen und Zusammenhänge müssen in sich konsistent sein.

- Eine wissenschaftliche Theorie muss überprüfbar sein, d.h. sie muss sich anhand von Evidenz be- insbesondere aber auch widerlegen lassen.

Viele religiöse Glaubenssätze erfüllen genau dieses Kriterium nicht – wenn die Erklärung für ein Phänomen darin besteht, dass ein allmächtiges Wesen es so geschaffen hat, dann entzieht sich diese Aussage jeder empirischen Überprüfbarkeit. Das bedeutet nicht, dass solche Erklärungen falsch sind, sie passen aber nicht in die wissenschaftliche Methodik und sollten nicht mit Theorien im wissenschaftlichen Sinne verwechselt werden.

Neben den Minimalansprüchen sollte eine gute Theorie zudem

- verträglich sein mit bereits bewährten älteren Theorien oder diese sogar in den eigenen Erklärungsbereich miteinschliessen;

- Erklärungswert besitzen, also nicht rein deskriptiv (=beschreibend) sein;

- allgemein sein, ihr Gegenstandsbereich soll also nicht zu speziell sein (das Phänomen erklären, nicht ein bestimmtes Beispiel);

- Prognosen ermöglichen, die in der Praxis auch eintreffen können, und damit falsifizierbar sein.

Eine wissenschaftliche Theorie wird nur in den seltensten Fällen «bewiesen». Möglich ist ein Beweis eigentlich nur dann, wenn ein vormals nur indirekt beobachtbares Phänomen direkt beobachtbar wird, z.B. durch technische Entwicklungen. Beispielsweise darf die Kugelform der Erde – ursprünglich eine von mehreren konkurrierenden Theorien – spätestens seit dem Beginn der Raumfahrt als Fakt gelten.

Analogie

Theorie ist ein allgemeines Konzept der Wissenschaft, kein spezifisch informatisches. Jedem fallen spontan Beispiele für den Unterschied von Theorie und Praxis ein.

Evidenz

In der Wissenschaftstheorie bezeichnet der Begriff «Evidenz» zumeist diejenigen empirischen Befunde, die Theorien bestätigen oder aufgrund derer Bestätigungsversuche scheitern.

Quelle: Wikipedia, Evidenz

Die präzise Definition von Begriffen wie «Evidenz» oder «Empirie» ist nicht unumstritten und teilweise abhängig vom jeweiligen Fachgebiet. Im Kontext dieses Kurses soll uns eine grobe Sichtweise genügen:

Als Evidenz bezeichnen wir verlässliche Informationen (bzw. Daten) über die Realität, also genau jene Fakten, die mithilfe einer Theorie erklärt werden sollen.

Die entscheidende Anforderung ist eben jene Verlässlichkeit: Wann ist eine Information über die Welt verlässlich genug, dass sie es wert wäre, von der Theorie berücksichtigt zu werden?

Evidenz wird gesammelt anhand von Beobachtungen der realen Welt. Beispielsweise könnte jemand davon berichten, dass im hohen Norden nachts bunte Lichter am Himmel flackern. Solche anekdotische Evidenz ist tendenziell wenig verlässlich – die entsprechende Person könnte schliesslich auch lügen, oder phantasieren, oder unter dem Einfluss von Drogen gestanden haben. Verlässlicher wird die Information, wenn viele Personen von einem solchen Phänomen berichten, wenn die Beobachtungen gut belegt sind und mehrere Quellen übereinstimmen, oder wenn die Beobachtung von einer besonders zuverlässigen Person gemacht wird – bis zum Mittelalter etwa galt die Autorität der Quelle als bester Beleg für die Verlässlichkeit einer Information.

Spätestens seit dem 17. Jahrhundert setzte sich die empirische Forschung als Standard für die Gewinnung wissenschaftlicher Evidenz durch, insbesondere die Methode des kontrollierten Experiments. Unter einem Experiment versteht man eine methodisch angelegte Untersuchung zur Gewinnung von Information (bzw. Daten) bzgl. eines bestimmten Phänomens. Eine Beobachtung oder Messung (beispielsweise der Polarlichter) wird also zielgerichtet durchgeführt, die Ergebnisse sowie alle relevanten Umweltbedingungen werden genauestens dokumentiert.

In der reinsten Form des Experiments wird ein Phänomen nicht in freier Wildbahn, sondern unter Laborbedingungen untersucht – das hat den Vorteil, dass man die relevanten Umweltbedingungen gezielt kontrollieren und variieren kann. So könnte man bspw. herausfinden, welchen Einfluss genau ein Magnetfeld auf die Entstehung von atmosphärischen Lichterscheinungen hat, indem man Atmosphäre und Magnetfeld im Labor nachstellt.

Die wichtigste Anforderung an ein Experiment ist, dass alle Aspekte so genau dokumentiert sein müssen, dass andere Forscher das Experiment wiederholen können und dadurch die Ergebnisse bestätigen oder widerlegen. Experimentell gewonnene Evidenz gilt genau wegen dieser Wiederholbarkeit als besonders zuverlässig.

Analogie

Evidenz ist ein allgemeines Konzept der Wissenschaft, kein spezifisch informatisches.

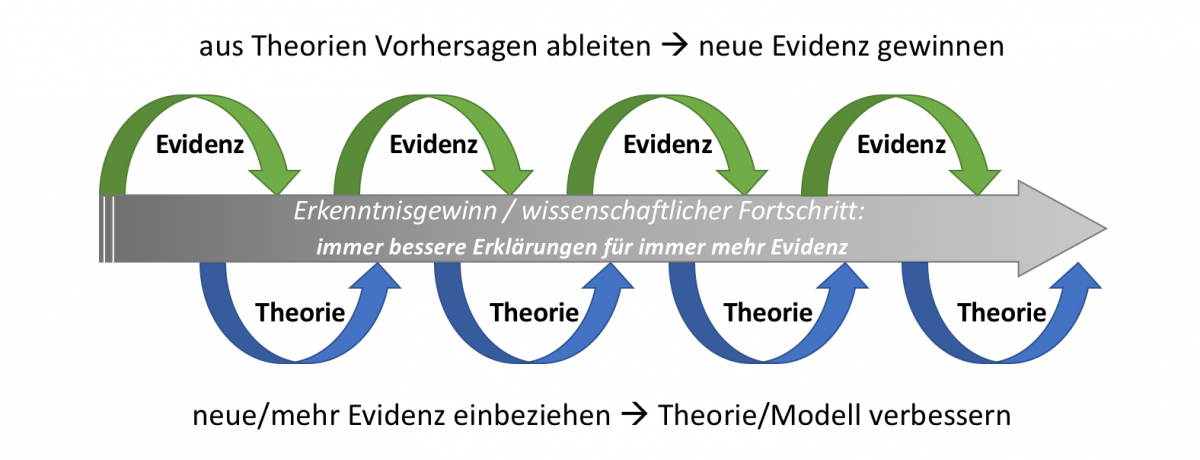

Das Ziel des wissenschaftlichen Systems ist es, mithilfe dieser Ansprüche an Theorie und Evidenz eine gemeinsame Basis zu schaffen, auf der man Erklärungsansätze vergleichen kann. In der modernen Wissenschaft forciert man diesen Konkurrenzkampf der Theorien, indem man insbesondere nach Situationen sucht, für die verschiedenen Theorien unterschiedliche Vorhersagen machen. Dann versucht man ebenjene Situation nachzustellen, beispielsweise in Form eines gezielten Experiments. Je nach Ausgang des Experiments wird dann zumindest eine der Theorien verworfen oder so angepasst, dass sie auch mit der neuen Evidenz vereinbar wird. Auf diese Weise konkurrieren verschiedene Erklärungsansätze oft über längere Zeit miteinander. Dafür, dass sich im Laufe der Zeit doch bestimmte Theorien durchsetzen, sind insbesondere zwei Qualitätsmerkmale verantwortlich:

- Einfachheit: Wenn verschiedene Theorien ähnlich gut zur vorhandenen Evidenz passen, dann gilt die einfachere Erklärung als die bessere. Dieses Prinzip ist bekannt unter dem Namen Ockhams Rasiermesser, bzw. Sparsamkeitsprinzip.

- Gegenstandsbereich: Wenn zwei Theorien bestimmte Phänomene – bzw. die zugehörige Evidenz – ähnlich gut erklären, eine davon aber noch auf weitere Phänomene anwendbar ist, dann gilt die allgemeinere Erklärung als die bessere.

Im Detail sind beide Qualitätsmerkmale problematisch: Die Einfachheit einer Erklärung ist oft nicht objektiv zu vergleichen und die Gegenstandsbereiche haben oft keine klare Einschlussbeziehung, z.B. wenn mehrere Theorien, neben einem gemeinsamen Kern, jeweils unterschiedliche zusätzliche Phänomene erklären. Zudem gibt es eine Interaktion zwischen den Qualitätsmerkmalen: Häufig ist eine allgemeinere Erklärung auch komplizierter als eine spezifische. So kommt es, dass z.B. die (einfachere) Newtonsche Mechanik in vielen Gebieten noch immer Anwendung findet, obwohl die (kompliziertere) Relativitätstheorie dieselben Phänomene und noch viel mehr erklärt.

Wissenschaftler tun also eigentlich zwei Dinge: Zum einen erarbeiten und verbessern sie Theorien/Modelle, zum anderen versuchen sie, durch Beobachtungen, Messungen und Experimente neue Evidenz zu schaffen, um die Theorien zu be- oder widerlegen. Und weil das alles im Detail nicht ganz einfach ist, verbringen sie ausserdem viel Zeit damit, sich darüber zu streiten, welche Evidenz verlässlicher und welche Theorie einfacher oder allgemeiner ist. Auf die Dauer jedoch – das ist das Essentielle an der wissenschaftlichen Methode – setzen sich die besseren Erklärungen durch, weil immer deutlicher wird, dass die aus der Theorie abgeleiteten Vorhersagen durch immer neue Evidenz bestätigt werden. Die rasanten technischen Entwicklungen der vergangenen 150 Jahre bezeugen den Erfolg der wissenschaftlichen Methode – insbesondere was naturwissenschaftliche Forschungsgebiete angeht.

Simulation als drittes Standbein der Wissenschaft

Und was hat das alles mit Informatik zu tun? Man kann behaupten, dass die Informatik eine neue Methode zur Verfügung stellt, mit deren Hilfe sich der wissenschaftliche Erkenntnisgewinn in den letzten Jahrzehnten noch einmal rasant beschleunigt hat: die Simulation.

Simulation

Menschen haben schon im Altertum begonnen, Naturphänomene mit allgemeingültigen Regeln zu beschreiben (Theorie). Mit der Zeit führten genauere Beobachtungen und gezielte Experimente zu Verbesserungen der Theorie und zu entsprechenden Berechnungsformeln. Für praktische Anwendungen waren diese Formeln allerdings oft zu komplex, sodass Näherungslösungen genügen mussten und manche Berechnungen gar nicht möglich waren. Erst seit der Verfügbarkeit von Rechenautomaten (also nach dem Zweiten Weltkrieg) konnten anspruchsvolle reale Sachverhalte genügend genau durch rein virtuelle, numerische Modelle repräsentiert werden (Simulation). Virtuelle Modelle sind insbesondere dort wichtig, wo materielle Experimente extrem teuer oder gar nicht möglich sind.

Virtuelle Modelle und Simulationen bilden heute neben Theorie und Experiment das dritte Standbein der wissenschaftlichen Erkenntnis in allen naturwissenschaftlichen und technischen Disziplinen sowie bereits auch in manchen Bereichen der Wirtschafts- und Sozialwissenschaften.

Quelle: Jürg Kohlas, Jürg Schmid, Carl August Zehnder (2013)

Bei einer Simulation wird die Theorie in ein numerisches Modell überführt, es wird also mithilfe von Algorithmen genau spezifiziert, wie welche Daten verarbeitet werden sollen. Auch die zu verarbeitenden Informationen – oft Referenzdaten genannt – müssen genau festgelegt werden, üblicherweise indem aus realen Experimenten oder Messungen gewonnene Evidenz digital angenähert oder sogar direkt eingespeist wird. Auf diese Weise überführt man die beiden wesentlichen Aspekte der wissenschaftlichen Methodik in ein virtuelles System und kann so die Interaktion aller Komponenten aktiv ausprobieren – eben simulieren.

Analogie

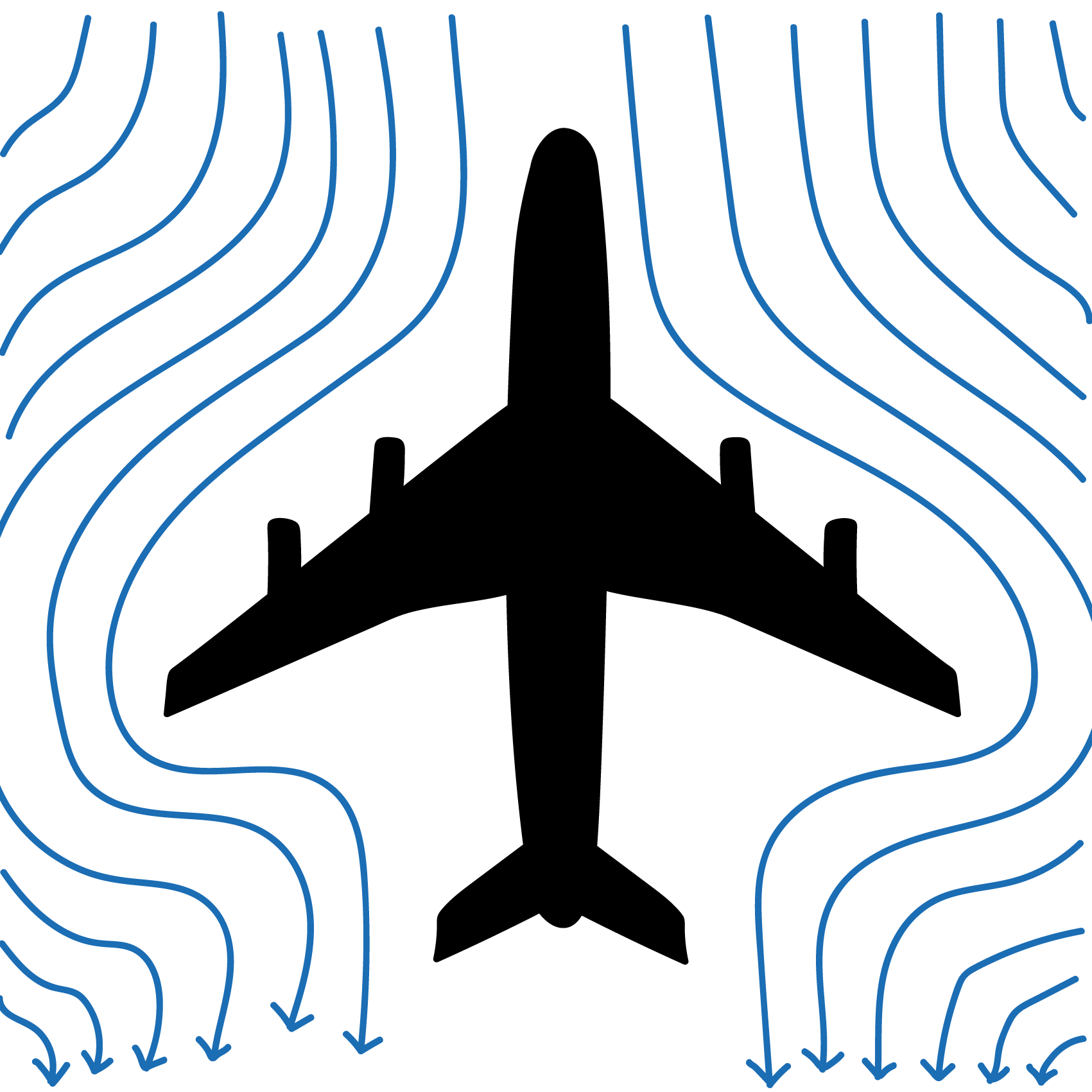

Wenn ich wissen möchte, ob mein neues Flugzeugdesign flugfähig ist, kann ich es als verkleinertes Modell nachbauen und in einem Windkanal testen. Auf diese Weise kann ich mir hoffentlich verschiedene Experimente und Abstürze mit dem echten Flugzeug sparen – vorausgesetzt, dass bei der Übersetzung von der Realität in die Simulation (Flugzeug → Modell & Umwelt → Windkanal) keine unzulässigen Vereinfachungen gemacht wurden.

Wie wichtig Simulationen in der Wissenschaft inzwischen sind, zeigt sich u.a. daran, dass sich in den meisten Fachgebieten – nicht nur in den Naturwissenschaften – eigene Unterbereiche mit Lehrstühlen und Ausbildungsgängen im Bereich Computational XY etabliert haben (z.B. Computational Physics, Computational Biology, Computational Medicine, Computational Economics, Computational Psychology, Computational Anthropology, Computational Linguistics). Gemeinsam haben diese Bereiche, dass es zumeist um die Erforschung von Systemen geht, in denen sich das Gesamtbild aus der Interaktion vieler Einzelteile ergibt. Weil diese Interaktionen selbst mit verhältnismässig einfachen Komponenten schnell komplex werden, gibt es oftmals gar keine andere Möglichkeit, als das System numerisch zu simulieren (und weil verschiedene solcher Systeme erstaunlich viele Gemeinsamkeiten aufweisen, sind Komplexe Systeme selbst inzwischen ein eigenständiges Forschungsgebiet).

Wozu simulieren?

«Dass die Entwicklung und der Einsatz von Simulationsverfahren bereits heute mit Fug und Recht als große Herausforderung für Wissenschaft und Wirtschaft bezeichnet werden können und in Zukunft noch stark an Bedeutung zulegen werden, kann schwerlich bestritten werden. Zu offenkundig ist, dass das klassische Instrumentarium – also theoretische Analyse und Experiment – auf sich alleine gestellt immer öfter an seine Grenzen stößt. So führt die Erfordernis einer möglichst realitätsnahen Beschreibung der zu untersuchenden Phänomene, Prozesse oder Systeme in aller Regel zu Modellen, die sich aufgrund ihres Komplexitätsgrades einer analytischen Behandlung entziehen. […] Andererseits sind auch den Experimentiermöglichkeiten in vielen Fällen Grenzen gesetzt. Manchmal sind Experimente schlichtweg unmöglich. Vorgänge aus der Astrophysik wie beispielsweise der Lebenszyklus einer Galaxie dauern bei weitem zu lange, als dass ein noch so geduldiger Astronom sie beobachten könnte. Auch klimatische Phänomene wie der Treibhauseffekt sind äußerst unzugänglich: Man kann eben den weltweiten CO2N Ausstoß nicht so ohne weiteres für drei Monate verdoppeln oder halbieren, um die Auswirkungen zu messen, und Laborexperimente werfen hier natürlich die Frage der Skalierbarkeit auf. […] In anderen Fällen sind Experimente zwar machbar, aber aufgrund gefährlicher oder irreversibler Begleiterscheinungen unerwünscht – man denke nur etwa an Lawinenabgänge, Tests von Kernwaffen oder an Versuche am Menschen in der Medizin.»

Quelle: Bungartz et al. (2002), Simulierte Welten – die Zukunft im Rechner, S.38.

Anhand der obigen Beispiele wird ersichtlich, dass virtuelle Experimente in einer Simulationsumgebung reale Experimente ersetzen oder zumindest ergänzen können – vorausgesetzt, der Zusammenhang zwischen Realität und Simulation kann als gesichert gelten. Um diesen Zusammenhang herzustellen, müssen die zugrundeliegenden Theorien in numerische Modelle überführt, also in allen Aspekten konkret spezifiziert werden – so gesehen fördern Simulationen insbesondere auch die Theorie- bzw. Modellbildung.

Simulationen können theoretische Analyse und reales Experiment nicht ersetzen, aber ergänzen und besser verknüpfen. Die virtuelle Umsetzung beider Aspekte eröffnet neue Möglichkeiten, so etwa in Bezug auf die Genauigkeit der Theorien/Modelle, die Menge und Qualität der berücksichtigten Daten und die Präzision der abgeleiteten Vorhersagen. In besonderem Masse gilt das für die Erforschung von Systemen, die durch analytische Herangehensweisen nur ungenügend abgebildet werden können, unter anderem aufgrund komplexer Interaktionen, stochastischer Komponenten oder extremer Datenmengen. Aus diesen Gründen leisten Simulationen in der modernen Wissenschaft einen wesentlichen Beitrag dazu, dass sich aus der Wechselwirkung von Theorie und Evidenz (beides ggf. virtuell simuliert) immer bessere Erklärungen für verschiedenste Phänomene und Prozesse ergeben.

Simulationen entwickeln und auswerten

Jede Simulation durchläuft drei Phasen:

SimulationenEinstieg.pptx

SimulationenEinstieg.pptx